Σύμφωνα με το Παγκόσμιο Οικονομικό Φόρουμ (WEF), ο αριθμός των deepfake βίντεο στο διαδίκτυο αυξάνεται κατά περίπου 900% ετησίως. Πολλές περιπτώσεις απάτης deepfake έχουν γίνει πολύ γνωστές, με αναφορές για παρενόχληση, εκδίκηση και απόπειρα απάτης με κρυπτονομίσματα. Αυτή τη φορά, οι ερευνητές της Kaspersky ρίχνουν φως στις τρεις κορυφαίες απάτες που βασίζονται σε deepfake και τις οποίες πρέπει να προσέχετε.

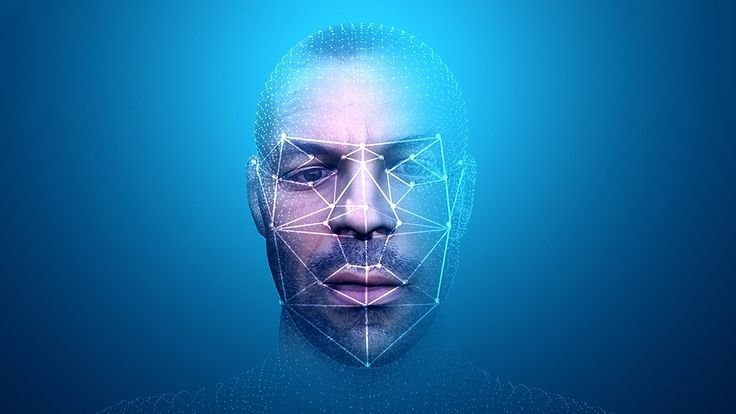

Η χρήση των νευρωνικών δικτύων και της βαθιάς μάθησης (“deep faking”) επέτρεψε στους χρήστες σε όλο τον κόσμο να βασίζονται σε εικόνες, βίντεο και ήχο για να δημιουργήσουν ρεαλιστικά βίντεο στα οποία το πρόσωπο και το σώμα είναι ψηφιακά παραποιημένα ώστε να μοιάζουν με διαφορετικό άτομο. Αυτά τα παραποιημένα βίντεο και εικόνες χρησιμοποιούνται συχνά για κακόβουλους σκοπούς, όπως η διάδοση ψευδών πληροφοριών.

Οικονομική απάτη

Τα Deepfakes μπορούν επίσης να χρησιμοποιηθούν για κοινωνική μηχανική, όπου κακόβουλοι χρήστες υποδύονται διασημότητες και χειραγωγούν εικόνες για να παρασύρουν τα θύματα στις “παγίδες” τους. Για παράδειγμα, ένα ψεύτικο βίντεο του Elon Musk που υποσχόταν υψηλές αποδόσεις από ένα ασταθές επενδυτικό σχήμα κρυπτονομισμάτων έγινε viral πέρυσι, με αποτέλεσμα τα θύματα αυτής της απάτης να χάσουν χρήματα. Για τη δημιουργία τέτοιων deepfakes, οι κακόβουλοι χρήστες χρησιμοποιούν πλάνα διασημοτήτων ή συνδυάζουν παλιά βίντεο και υπόσχονται να διπλασιάσουν τυχόν πληρωμές κρυπτονομισμάτων που θα λάβουν, μεταδίδοντάς τα ζωντανά σε πλατφόρμες κοινωνικής δικτύωσης.

Πορνογραφικά deepfakes

Μια άλλη χρήση των deepfakes είναι η εισβολή στην ιδιωτική ζωή των ανθρώπων. Τα deepfake βίντεο μπορούν να δημιουργηθούν προσθέτοντας το πρόσωπο ενός ατόμου σε ένα πορνογραφικό βίντεο για να προκαλέσουν βλάβη και δυσφορία. Κάποτε κυκλοφόρησαν στο διαδίκτυο deepfake βίντεο στα οποία το πρόσωπο μιας διασημότητας τοποθετούνταν πάνω στο σώμα ενός ηθοποιού ή μιας ηθοποιού που εμφανιζόταν σε ένα πορνογραφικό βίντεο. Ως αποτέλεσμα, σε αυτές τις περιπτώσεις, τα θύματα που δέχθηκαν επίθεση διασύρθηκαν και τα δικαιώματά τους παραβιάστηκαν.

Επιχειρηματικοί κίνδυνοι

Τα deepfakes χρησιμοποιούνται συχνά ακόμη και για επιχειρηματικούς σκοπούς, όπως ο εκβιασμός στελεχών εταιρειών και η βιομηχανική κατασκοπεία. Για παράδειγμα, υπάρχει μια γνωστή περίπτωση όπου εγκληματίες του κυβερνοχώρου εξαπάτησαν με επιτυχία έναν διευθυντή τράπεζας στα Ηνωμένα Αραβικά Εμιράτα και έκλεψαν 35 εκατομμύρια δολάρια ΗΠΑ χρησιμοποιώντας deepfake ήχο. Κατάφεραν να δημιουργήσουν ένα πειστικό deepfake απλά κάνοντας μια σύντομη ηχογράφηση της φωνής του αφεντικού του υπαλλήλου. Σε μια άλλη περίπτωση, ένας απατεώνας προσπάθησε να εξαπατήσει την Binance, τη μεγαλύτερη πλατφόρμα κρυπτονομισμάτων. Τα στελέχη της Binance εξεπλάγησαν όταν άρχισαν να λαμβάνουν ευχαριστήρια μηνύματα για συναντήσεις Zoom στις οποίες δεν είχαν συμμετάσχει ποτέ. Για πρώτη φορά, ο απατεώνας μπόρεσε να δημιουργήσει ένα deepfake χρησιμοποιώντας εικόνες του ίδιου που ήταν διαθέσιμες στο διαδίκτυο, τις οποίες στη συνέχεια χρησιμοποίησε σε μια διαδικτυακή συνάντηση για να μιλήσει εκ μέρους του στελέχους.

Σε γενικές γραμμές, οι απατεώνες που εκμεταλλεύονται τα deepfakes προσπαθούν να χειραγωγήσουν την κοινή γνώμη παραπληροφορώντας, εκφοβίζοντας ή ακόμη και κατασκοπεύοντας τους ανθρώπους- σύμφωνα με τις προειδοποιήσεις του FBI, οι διευθυντές ανθρώπινου δυναμικού είναι ήδη επιφυλακτικοί απέναντι στους υποψηφίους που υποβάλλουν αίτηση για απομακρυσμένες θέσεις εργασίας χρησιμοποιώντας deepfakes. Στην περίπτωση της Binance, οι επιτιθέμενοι θα μπορούσαν να δημιουργήσουν ένα deepfake χρησιμοποιώντας την εικόνα ενός ατόμου από το διαδίκτυο και να προσθέσουν ακόμη και τη φωτογραφία αυτού του ατόμου στο βιογραφικό τους σημείωμα. Με αυτόν τον τρόπο, θα μπορούσαν να εξαπατήσουν το προσωπικό ανθρώπινου δυναμικού και, αν αργότερα κατάφερναν να λάβουν μια προσφορά εργασίας, θα μπορούσαν να κλέψουν δεδομένα για τον εργοδότη.

Θα πρέπει επίσης να ληφθεί υπόψη ότι τα deepfakes είναι μια πολύ δαπανηρή μορφή απάτης και, ως εκ τούτου, απαιτούν υψηλή χρηματοδότηση. Προηγούμενη έρευνα της Kaspersky αποκάλυψε τους τύπους των deepfakes που πωλούνται στο darknet και το κόστος τους. Εάν ο μέσος χρήστης βρει απλό λογισμικό στο διαδίκτυο και προσπαθήσει να δημιουργήσει ένα deepfake, τα αποτελέσματα μπορεί να είναι μη ρεαλιστικά. Λίγοι άνθρωποι θα αγόραζαν ένα deepfake κακής ποιότητας, με καθυστερημένες εκφράσεις προσώπου και θολά σαγόνια.

Επομένως, οι εγκληματίες του κυβερνοχώρου χρειάζονται μεγάλο όγκο δεδομένων, συμπεριλαμβανομένων φωτογραφιών και βίντεο κλιπ του ατόμου που θέλουν να αντιγράψουν, προκειμένου να διαπράξουν μια τέτοια απάτη. Οι διαφορετικές γωνίες, η φωτεινότητα και οι εκφράσεις του προσώπου έχουν σημαντικό αντίκτυπο στην τελική ποιότητα. Η σύγχρονη ισχύς του υπολογιστή και το λογισμικό είναι επίσης απαραίτητα για την επίτευξη ενός ρεαλιστικού αποτελέσματος. Αυτό απαιτεί τεράστιους πόρους και είναι διαθέσιμο μόνο σε έναν πολύ μικρό αριθμό εγκληματιών του κυβερνοχώρου. Ως εκ τούτου, παρά τους κινδύνους που ενέχουν τα deepfakes, εξακολουθούν να αποτελούν μια πολύ σπάνια απειλή και μόνο λίγοι αγοραστές μπορούν να το αντέξουν οικονομικά – άλλωστε, η τιμή ανά λεπτό των deepfakes μπορεί να ξεκινά από 20.000 δολάρια ΗΠΑ. “Μία από τις σοβαρότερες απειλές για τις εταιρείες δεν είναι απαραίτητα η κλοπή εταιρικών δεδομένων. Σε ορισμένες περιπτώσεις, η ίδια η εικόνα της εταιρείας μπορεί να πληγεί από το κοινό. Για παράδειγμα, μπορεί να κυκλοφορήσει ένα βίντεο με έναν διευθυντή να κάνει αμφιλεγόμενες δηλώσεις για ένα ευαίσθητο θέμα. Για μια εταιρεία, αυτό θα μπορούσε να οδηγήσει γρήγορα σε πτώση της χρηματιστηριακής αγοράς. Παρά το γεγονός ότι τέτοιες απειλές είναι πολύ επικίνδυνες, η πιθανότητα μιας τέτοιας επίθεσης παραμένει εξαιρετικά χαμηλή λόγω του υψηλού κόστους δημιουργίας βαθιών απομιμήσεων και του μικρού αριθμού κακόβουλων χρηστών που μπορούν να δημιουργήσουν υψηλής ποιότητας βαθιές απομιμήσεις”, αναφέρει ο ανώτερος υπεύθυνος ασφαλείας της Kaspersky Expert Dmitry Anikin σχολίασε.

“Αυτό που μπορείτε να κάνετε σήμερα είναι να αναγνωρίσετε τα βασικά χαρακτηριστικά των deepfake βίντεο που πρέπει να προσέχετε και να είστε σε εγρήγορση σχετικά με τα φωνητικά μηνύματα και τα βίντεο που λαμβάνετε. Επίσης, βεβαιωθείτε ότι οι υπάλληλοί σας καταλαβαίνουν τι είναι ένα deepfake και πώς μπορούν να το αναγνωρίσουν – για παράδειγμα, σπασμωδικές κινήσεις, αλλαγές στο χρώμα του δέρματος, αστεία ανοιγοκλείσιμο των ματιών ή όχι”, συνέχισε.

Η συνεχής παρακολούθηση των ροών χρήματος στο darknet μπορεί να παράσχει πολύτιμες πληροφορίες σχετικά με τη βιομηχανία των deepfake, επιτρέποντας στους ερευνητές να κατανοήσουν τις τελευταίες τάσεις και δραστηριότητες των απειλητικών παραγόντων σε αυτόν τον τομέα. Με την παρακολούθηση του darknet, οι ερευνητές μπορούν να ανακαλύψουν νέα εργαλεία, υπηρεσίες και αγορές που χρησιμοποιούνται για τη δημιουργία και τη διανομή deepfakes. Η εν λόγω παρακολούθηση αποτελεί βασικό συστατικό της έρευνας για τα deepfake και συμβάλλει στη βελτίωση της κατανόησης του εξελισσόμενου τοπίου απειλών. Η υπηρεσία Digital Footprint Intelligence της Kaspersky περιλαμβάνει αυτού του είδους την παρακολούθηση για να βοηθήσει τους πελάτες να παραμείνουν μπροστά από τις εξελίξεις όσον αφορά τις απειλές που σχετίζονται με τα deepfake.

Μάθετε περισσότερα για τη βιομηχανία deepfake στο Kaspersky Daily.

Για να προστατευτείτε από απειλές που σχετίζονται με deepfakes, η Kaspersky συνιστά:

-

Ενισχύστε το “ανθρώπινο τείχος προστασίας” της εταιρείας: βεβαιωθείτε ότι οι εργαζόμενοι κατανοούν τι είναι τα deepfakes, πώς λειτουργούν και ποιες προκλήσεις δημιουργούν. Παρέχετε συνεχείς δραστηριότητες ευαισθητοποίησης και κατάρτισης για να βοηθήσετε τους υπαλλήλους να εντοπίζουν τα deepfakes: η πλατφόρμα Kaspersky Automated Security Awareness Platform βοηθά τους υπαλλήλους να παραμένουν ενήμεροι για τις τελευταίες απειλές και να βελτιώνουν τα επίπεδα ψηφιακού αλφαβητισμού τους.

-

Λήψη εμπεριστατωμένων πληροφοριών από αξιόπιστες πηγές. Ο χαμηλός πληροφοριακός αλφαβητισμός παραμένει καθοριστικός παράγοντας για την εξάπλωση των deepfakes.

-

Αποκτήστε καλά πρωτόκολλα όπως το “trust but verify”. Μια προσεκτική στάση απέναντι στα μηνύματα ήχου και βίντεο δεν εγγυάται ότι οι άνθρωποι δεν θα ξεγελαστούν ποτέ, αλλά μπορεί να βοηθήσει στην αποφυγή παγίδων.

-

Τα βίντεο Deep-fake χαρακτηρίζονται από αδέξιες κινήσεις, αλλαγές φωτισμού από καρέ σε καρέ, αλλαγές στο χρώμα του δέρματος, λάθος ανοιγοκλείσιμο των ματιών, μη συγχρονισμένα χείλη και συνομιλία, ψηφιακά δακτυλικά αποτυπώματα στην εικόνα, χαμηλό φωτισμό και σκόπιμα χαμηλής ποιότητας βίντεο κ.λπ., τα οποία είναι σημαντικό να γνωρίζετε για να αποφύγετε να πέσετε θύμα.