Ένας ανοιχτού κώδικα ανιχνευτής, δοκιμασμένος σε μηχανήματα Windows, MAC, linux αλλά και σε WSL.

Table of Contents

Τι μπορεί να κάνει το SourceWolf;

- Ανιχνεύστε responses για να βρείτε κρυμμένα endpoints, είτε στέλνοντας αιτήματα είτε από τα τοπικά αρχεία απόκρισης (εάν υπάρχουν).

- Δημιουργήστε μια λίστα μεταβλητών javascript από το source

- Εξαγάγετε όλους τους συνδέσμους κοινωνικών μέσων από τους ιστότοπους για να εντοπίσετε δυνητικά σπασμένους συνδέσμους

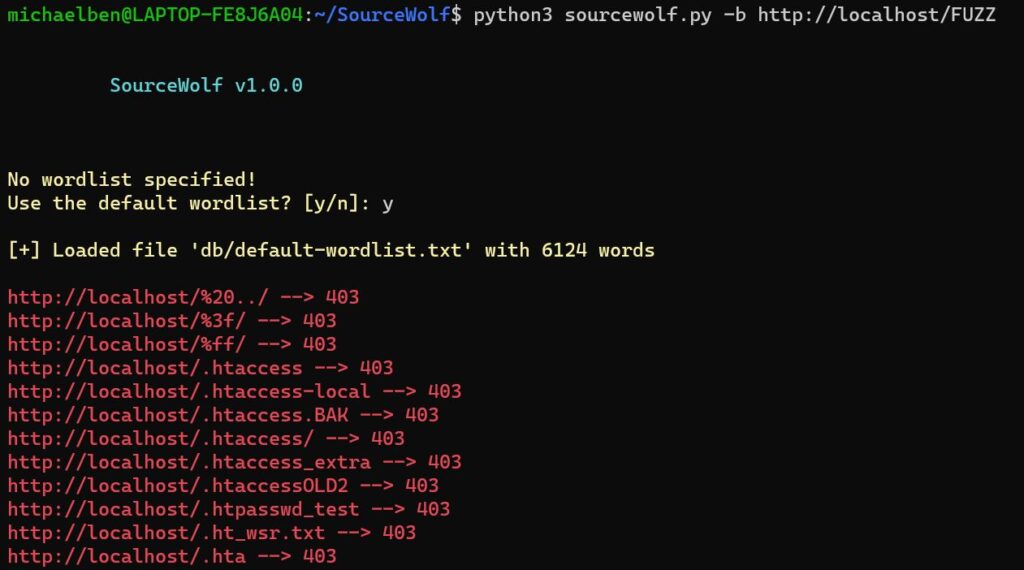

- Κάνετε Brute forcing χρησιμοποιώντας μια wordlist (λίστα κωδικών).

- Λάβετε τους κωδικούς κατάστασης για μια λίστα διευθύνσεων URL / Filtering των live domains από μια λίστα κεντρικών υπολογιστών.

Όλα τα παραπάνω χαρακτηριστικά εκτελούνται με μεγάλη ταχύτητα.

- Το SourceWolf χρησιμοποιεί Session module από τη βιβλιοθήκη των αιτημάτων, που σημαίνει, επαναχρησιμοποιεί τη σύνδεση TCP, καθιστώντας την πραγματικά γρήγορη.

- Το SourceWolf σάς παρέχει μια επιλογή για ανίχνευση των responses αρχείων τοπικά , ώστε να μην στέλνετε αιτήματα ξανά σε ένα endpoint, του οποίου η απάντηση έχετε ήδη ένα αντίγραφο.

- Τα endpoints είναι σε πλήρη μορφή με έναν κεντρικό υπολογιστή όπως

https://example.com/api/adminκαι όχι όπως/api/admin. Αυτό μπορεί να είναι χρήσιμο, όταν σαρώνετε μια λίστα από hosts.

Εγκατάσταση

- git clone https://github.com/micha3lb3n/SourceWolf (ή) Κατεβάστε την τελευταία έκδοση χειροκίνητα!

- cd SourceWolf /

- pip3 install -r requirements.txt

Χρήση

> python3 sourcewolf.py -h

-l LIST, --list LIST List of javascript URLs

-u URL, --url URL Single URL

-t THREADS, --threads THREADS

Number of concurrent threads to use (default 5)

-o OUTPUT_DIR, --output directory-name OUTPUT_DIR

Store URL response text in a directory for further analysis

-s STATUS_CODE_FILE, --store-status-code STATUS_CODE_FILE

Store the status code in a file

-b BRUTE, --brute BRUTE

Brute force URL with FUZZ keyword (--wordlist must also be used along with this)

-w WORDLIST, --wordlist WORDLIST

Wordlist for brute forcing URL

-v, --verbose Verbose mode (displays all the requests that are being sent)

-c CRAWL_OUTPUT, --crawl-output CRAWL_OUTPUT

Output directory to store the crawled output

-d DELAY, --delay DELAY

Delay in the requests (in seconds)

--timeout TIMEOUT Maximum time to wait for connection timing out (in seconds)

--headers HEADERS Add custom headers (Must be passed in as {'Token': 'YOUR-TOKEN-HERE'}) --> Dictionary format

--cookies COOKIES Add cookies (Must be passed in as {'Cookie': 'YOUR-COOKIE-HERE'}) --> Dictionary format

--only-success Only print 2XX responses

--local LOCAL Directory with local response files to crawl for

--no-colors Remove colors from the output

--update-info Check for the latest version, and update if required

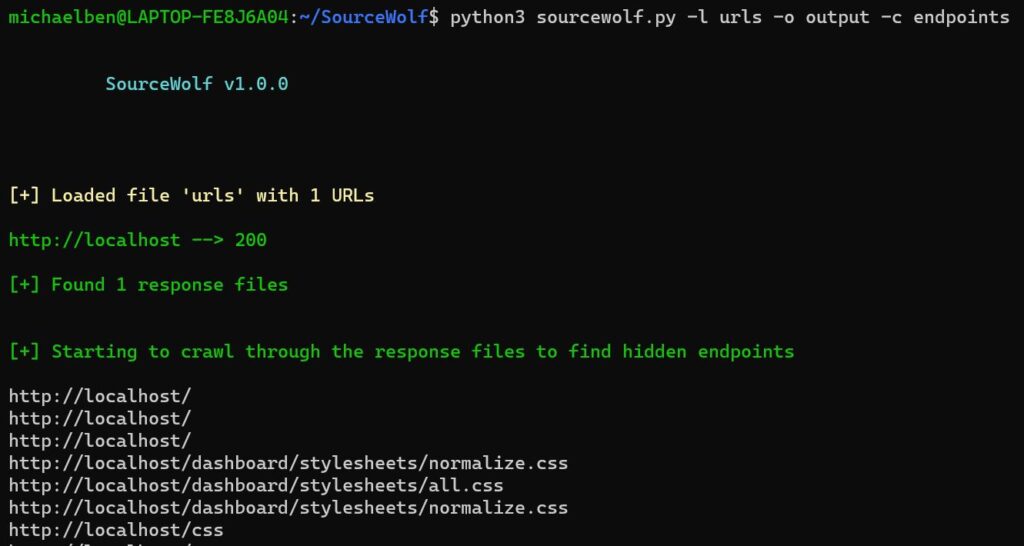

Στιγμιότυπα εφαρμογής

Μπορείτε να κατεβάσετε το πρόγραμμα από εδώ.