Αν το Deepfake σας τρόμαξε ή έστω σας διασκέδασε, το Deepfake με τεχνητή νοημοσύνη μάλλον θα προκαλέσει χάος. Δείτε ποιο είναι το μέλλον των AI Deepfakes.

Τα ενδεικτικά σημάδια μιας deepfake εικόνας ή βίντεο ήταν εύκολο να εντοπιστούν, αλλά η τεχνητή νοημοσύνη απογείωσε την τεχνολογία και πλέον τα ψεύτικα media γίνονται πολύ πειστικά, γεγονός που μας κάνει να αμφισβητούμε σχεδόν όλα όσα βλέπουμε και ακούμε.

Με κάθε νέο μοντέλο τεχνητής νοημοσύνης που κυκλοφορεί, τα ενδεικτικά σημάδια μιας ψεύτικης εικόνας μειώνονται και για να επιδεινωθεί η σύγχυση, μπορείτε τώρα να δημιουργήσετε deepfake βίντεο, με κλώνους φωνής των αγαπημένων σας προσώπων και να κατασκευάσετε ψεύτικα άρθρα μέσα σε λίγα δευτερόλεπτα.

Για να αποφύγετε να σας ξεγελάσουν τα deepfakes τεχνητής νοημοσύνης, αξίζει να γνωρίζετε τι είδους κινδύνους θέτουν.

Η εξέλιξη των Deepfakes

Ένα deepfake δείχνει ένα άτομο να κάνει κάτι, που δεν συνέβη ποτέ στην πραγματική ζωή. Είναι εντελώς ψεύτικο. Γελάμε με τα deepfakes όταν κοινοποιούνται στο διαδίκτυο ως αστείο, αλλά δεν είναι όλα καλοπροαίρετα και δεν προκαλούν όλα γέλια.

Στο παρελθόν, τα deepfakes δημιουργούνταν με τη λήψη μιας υπάρχουσας φωτογραφίας και την αλλαγή της σε ένα λογισμικό επεξεργασίας εικόνων όπως το Photoshop. Αλλά αυτό που ξεχωρίζει ένα AI deepfake είναι ότι μπορεί να δημιουργηθεί από την αρχή, χρησιμοποιώντας αλγόριθμους βαθιάς εκμάθησης.

Το λεξικό Merriam-Webster ορίζει το deepfake ως:

Μια εικόνα ή ηχογράφηση που έχει τροποποιηθεί και χειραγωγηθεί πειστικά, για να παραποιηθεί κάποιος ότι κάνει ή λέει κάτι που στην πραγματικότητα δεν έγινε ή δεν ειπώθηκε ποτέ.

Αλλά με την πρόοδο στην τεχνολογία AI, αυτός ο ορισμός αρχίζει να φαίνεται ξεπερασμένος. Με τη χρήση εργαλείων AI, τα deepfakes περιλαμβάνουν πλέον εικόνες, κείμενο, βίντεο και κλωνοποίηση φωνής. Μερικές φορές, και οι τέσσερις τρόποι δημιουργίας AI χρησιμοποιούνται ταυτόχρονα.

Επειδή είναι μια αυτοματοποιημένη διαδικασία που είναι απίστευτα γρήγορη και φθηνή στη χρήση, είναι το τέλειο εργαλείο για την παραγωγή deepfakes με ρυθμό που δεν έχουμε ξαναδεί. Και το βασικό χωρίς να χρειάζεται να ξέρετε τίποτα σχετικά με τον τρόπο επεξεργασίας φωτογραφιών, βίντεο ή ήχου.

Οι μεγάλοι κίνδυνοι του AI Deepfakes

Υπάρχει ήδη μια σειρά από γεννήτριες βίντεο AI (όπως οι GliaCloud, Synthesia κλπ), μαζί με πολλές γεννήτριες φωνής AI (όπως οι Replica Studios, FakeYou κλπ). Ρίξτε στο καζάνι και ένα μεγάλο μοντέλο γλώσσας, όπως το GPT-4 και θα έχετε μια συνταγή για τη δημιουργία των πιο πιστευτών deepfakes που έχουμε δει στη σύγχρονη ιστορία μέχρι τώρα.

Η επίγνωση των διαφορετικών ειδών τεχνητής νοημοσύνης και του τρόπου με τον οποίο μπορούν να χρησιμοποιηθούν για να σας εξαπατήσουν, είναι ένας τρόπος για να αποφύγετε την παραπλάνηση. Ακολουθούν μερικά μόνο σοβαρά παραδείγματα για το πώς η τεχνολογία deepfake AI αποτελεί πραγματική απειλή.

1. Κλοπή ταυτότητας με AI

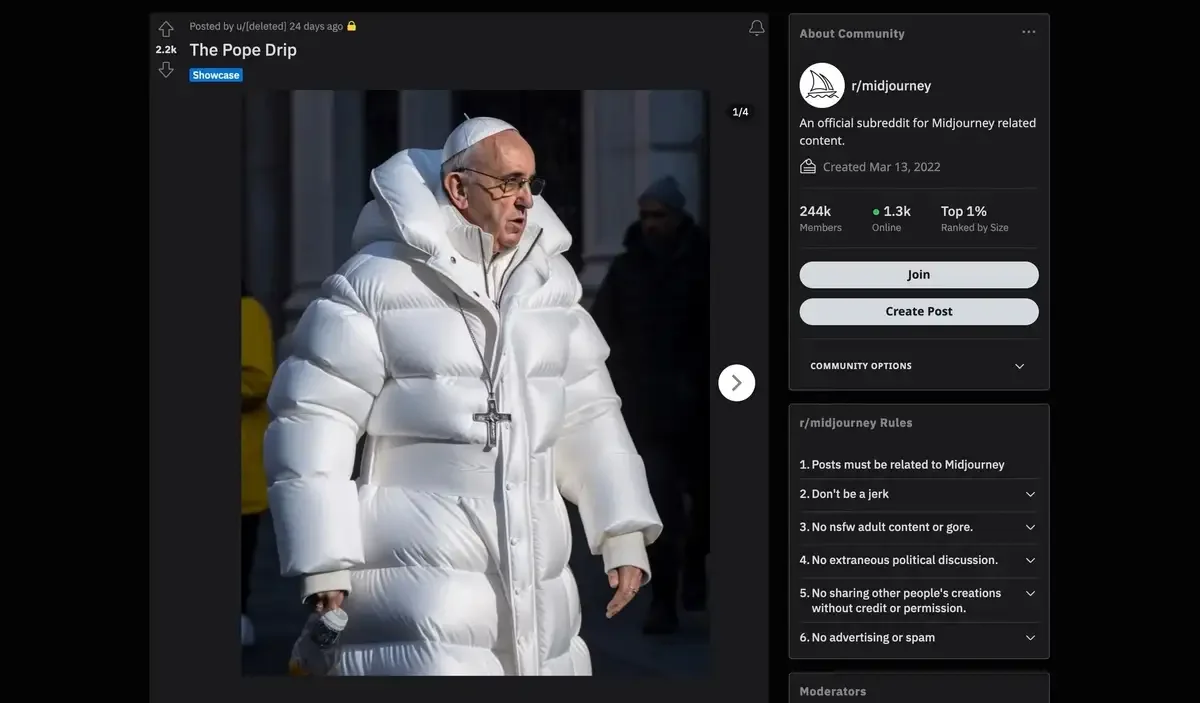

Μπορεί να τα έχετε δει. Μεταξύ των πρώτων πραγματικά viral deepfakes τεχνητής νοημοσύνης που διαδόθηκαν σε όλο τον κόσμο, ήταν μια εικόνα του Ντόναλντ Τραμπ που συνελήφθη και μία του Πάπα Φραγκίσκου με ένα λευκό τζάκετ.

Φαίνεται σαν μια αθώα εικόνα, με θέμα τι μπορεί να φορέσει μια διάσημη θρησκευτική φιγούρα μια κρύα μέρα στη Ρώμη. Από την άλλη όμως η παρακάτω εικόνα δείχνει μια πολιτική προσωπικότητα σε σοβαρά προβλήματα με το νόμο, και λογικά έχει πολύ μεγαλύτερες συνέπειες αν εκληφθεί ως πραγματική.

Making pictures of Trump getting arrested while waiting for Trump's arrest. pic.twitter.com/4D2QQfUpLZ

— Eliot Higgins (@EliotHiggins) March 20, 2023

Μέχρι στιγμής, οι άνθρωποι όταν δημιουργούσαν deepfakes με AI έχουν στοχεύσει κυρίως διασημότητες, πολιτικές προσωπικότητες και άλλα διάσημα άτομα. Εν μέρει, αυτό συμβαίνει επειδή διάσημα άτομα έχουν πολλές φωτογραφίες τους στο διαδίκτυο που πιθανότατα βοήθησαν στην εκπαίδευση του μοντέλου της τεχνητής νοημοσύνης.

Στην περίπτωση μιας συσκευής δημιουργίας εικόνων με τεχνητή νοημοσύνη, όπως το Midjourney, που χρησιμοποιήθηκε τόσο στο deepfake του Τραμπ όσο και στον Πάπα, ένας χρήστης χρειάζεται απλώς να εισάγει ένα κείμενο που να περιγράφει αυτό που θέλει να δει.

Λέξεις-κλειδιά μπορούν να χρησιμοποιηθούν για τον καθορισμό του στυλ τέχνης, όπως “φωτορεαλισμός”, και τα αποτελέσματα μπορούν να βελτιωθούν με την αναβάθμιση της ανάλυσης.

Μπορείτε εξίσου εύκολα να μάθετε να χρησιμοποιείτε το Midjourney και να το δοκιμάσετε μόνοι σας, αλλά για προφανείς ηθικούς και νομικούς λόγους, θα πρέπει να αποφύγετε να δημοσιεύσετε αυτές τις εικόνες λέγοντας ότι είναι αληθινές.

Δυστυχώς, το να είσαι ένας μέσος, μη διάσημος άνθρωπος δεν εγγυάται ότι είσαι ασφαλής από το deepfake με τεχνητή νοημοσύνη.

Το πρόβλημα έγκειται σε ένα βασικό χαρακτηριστικό που προσφέρουν οι γεννήτριες εικόνων AI: τη δυνατότητα να ανεβάσετε τη δική σας εικόνα και να την χειριστείτε με AI. Και ένα εργαλείο, όπως το Outpainting στο DALL-E 2, μπορεί να επεκτείνει μια υπάρχουσα εικόνα πέρα από τα σύνορά της, εισάγοντας μια προτροπή κειμένου και περιγράφοντας τι άλλο θα θέλατε να δημιουργήσετε.

Εάν κάποιος άλλος το έκανε αυτό με τις φωτογραφίες σας, οι κίνδυνοι θα μπορούσαν να είναι πολύ μεγαλύτεροι από το deepfake του Πάπα με ένα λευκό σακάκι.

Θα μπορούσε να το χρησιμοποιήσει οπουδήποτε, προσποιούμενος ότι είστε εσείς. Ενώ οι περισσότεροι άνθρωποι χρησιμοποιούν γενικά την τεχνητή νοημοσύνη με καλές προθέσεις, υπάρχουν πολύ λίγοι περιορισμοί που τους εμποδίζουν να το χρησιμοποιούν για να προκαλέσουν βλάβη, ειδικά σε περιπτώσεις κλοπής ταυτότητας.

2. Deepfake Voice Clone Scams

Με τη βοήθεια της τεχνητής νοημοσύνης, τα deepfakes έχουν ξεπεράσει τα όρια για τα οποία οι περισσότεροι από εμάς δεν ήμασταν προετοιμασμένοι: ψεύτικοι κλώνοι φωνής. Με μια μικρή ποσότητα πρωτότυπου ήχου (ίσως από ένα βίντεο TikTok που είχατε δημοσιεύσει κάποτε ή ένα βίντεο στο YouTube στο οποίο εμφανίζεστε) ένα μοντέλο τεχνητής νοημοσύνης μπορεί να αναπαράγει τη μοναδική φωνή σας.

Είναι παράξενο και τρομακτικό να δεχτείτε ένα τηλεφώνημα που ο συνομιλητής ακούγεται σαν μέλος της οικογένειας σας, ή φίλος ή συνάδελφος.

Μην εμπιστεύεστε τη φωνή. Καλέστε το άτομο που υποτίθεται ότι επικοινώνησε μαζί σας και επαληθεύστε την ιστορία. Χρησιμοποιήστε έναν αριθμό τηλεφώνου που γνωρίζετε ότι είναι δικός του. Εάν δεν μπορείτε να προσεγγίσετε το αγαπημένο σας πρόσωπο, προσπαθήστε να έρθετε σε επαφή μαζί του μέσω ενός άλλου μέλους της οικογένειας ή των φίλων του.

Η Washington Post ανέφερε μια περίπτωση ενός ζευγαριού, γύρω στα 70, που έλαβε ένα τηλεφώνημα από κάποιον που ακουγόταν ακριβώς όπως ο εγγονός του. Ήταν στη φυλακή και χρειαζόταν επειγόντως χρήματα για εγγύηση. Μη έχοντας άλλο λόγο να αμφιβάλλουν με ποιον μιλούσαν, προχώρησαν και παρέδωσαν τα χρήματα στον απατεώνα.

Δεν κινδυνεύει μόνο η παλαιότερη γενιά. Ο Guardian ανέφερε ένα άλλο παράδειγμα τραπεζικού διευθυντή που ενέκρινε μια συναλλαγή 35 εκατομμυρίων δολαρίων μετά από μια σειρά «ψεύτικων κλήσεων» από κάποιον που πίστευαν ότι ήταν διευθυντής τράπεζας.

3. Fake News Μαζικής Παραγωγής

Τα μοντέλα γλωσσών, όπως το ChatGPT, είναι πολύ καλά εκπαιδευμένα στην παραγωγή κειμένου που ακούγεται σαν άνθρωπος και προς το παρόν δεν έχουμε αποτελεσματικά εργαλεία για να εντοπίσουμε τη διαφορά. Σε λάθος χέρια, οι ψεύτικες ειδήσεις και οι θεωρίες συνωμοσίας μπορούν να παραχθούν φτηνά και θα χρειαστεί πολύ περισσότερος χρόνος για να απομυθοποιηθούν.

Η διάδοση παραπληροφόρησης δεν είναι κάτι νέο φυσικά, αλλά μια ερευνητική εργασία που δημοσιεύτηκε στο arXiv τον Ιανουάριο του 2023 εξηγεί ότι το πρόβλημα έγκειται στο πόσο εύκολο είναι να κλιμακωθεί με τα εργαλεία τεχνητής νοημοσύνης. Το αναφέρουν ως “εκστρατείες επιρροής που δημιουργούνται από την τεχνητή νοημοσύνη”, οι οποίες λένε ότι θα μπορούσαν, για παράδειγμα, να χρησιμοποιηθούν από πολιτικούς για την ανάθεση των πολιτικών τους εκστρατειών.

Ο συνδυασμός περισσότερων από μία πηγών που δημιουργούνται από AI, δημιουργεί ένα deepfake υψηλού επιπέδου. Για παράδειγμα, ένα μοντέλο τεχνητής νοημοσύνης μπορεί να δημιουργήσει μια καλογραμμένη και πειστική είδηση που θα συνοδεύεται από την ψεύτικη εικόνα του Ντόναλντ Τραμπ που συνελήφθη. Αυτό του δίνει περισσότερη νομιμότητα από ό,τι αν η εικόνα κοινοποιούνταν από μόνη της.

Οι ψεύτικες ειδήσεις δεν περιορίζονται επίσης σε εικόνες και γραπτά, οι εξελίξεις στη δημιουργία βίντεο με τεχνητή νοημοσύνη σημαίνουν ότι βλέπουμε περισσότερα deepfake βίντεο να εμφανίζονται. Εδώ είναι ένα από τον Ρόμπερτ Ντάουνι Τζούνιορ που μπολιάστηκε σε ένα βίντεο του Έλον Μασκ, και που δημοσιεύτηκε από το κανάλι του YouTube Deepfakery.

Η δημιουργία ενός deepfake μπορεί να είναι τόσο απλή όσο η λήψη μιας εφαρμογής. Μπορείτε να χρησιμοποιήσετε μια εφαρμογή, όπως το TokkingHeads, για να μετατρέψετε στατικές εικόνες σε κινούμενα είδωλα. Αυτό σας επιτρέπει να ανεβάσετε τη δική σας εικόνα και ήχο για να φαίνεται ότι το άτομο μιλάει.

Ως επί το πλείστον είναι διασκεδαστικό, αλλά υπάρχει επίσης πιθανότητα να δημιουργήσει προβλήματα. Μας δείχνει πόσο εύκολο είναι να χρησιμοποιήσουμε την εικόνα για να φαίνεται ότι το άτομο αυτό πρόφερε λέξεις που δεν είπε ποτέ.

Μην ξεγελαστείτε από ένα AI Deepfake

Τα Deepfakes μπορούν να αναπτυχθούν γρήγορα, με πολύ μικρό κόστος και με χαμηλή τεχνογνωσία ή απαιτούμενη υπολογιστική ισχύ. Μπορούν να λάβουν το σχήμα μιας παραγόμενης εικόνας, ενός κλώνου φωνής ή ενός συνδυασμού εικόνων, ήχου και κειμένου που δημιουργούνται από AI.

Κάποτε ήταν πολύ πιο δύσκολο και απαιτητικό να δημιουργηθεί ένα deepfake, αλλά τώρα, με πολλές εφαρμογές AI εκεί έξω, σχεδόν οποιοσδήποτε έχει πρόσβαση στα εργαλεία που χρησιμοποιούνται για τη δημιουργία deepfakes. Καθώς η τεχνολογία deepfake με AI γίνεται όλο και πιο προηγμένη, και αξίζει να παρακολουθείτε στενά τους κινδύνους που εγκυμονεί.